Por padrão, o Copilot Chat usa o modelo grande de linguagem GPT-4o da OpenAI. Trata-se de um modelo altamente proficiente que tem bom desempenho para tarefas de geração de texto, como sumarização e chat baseado em conhecimento. O modelo também é capaz de raciocínio, resolução de problemas matemáticos complexos e codificação.

No entanto, você não está limitado a usar esse modelo. Você pode escolher entre uma seleção de outros modelos, cada um com os próprios pontos fortes específicos. Você pode ter um modelo favorito que gosta de usar ou pode preferir usar um modelo específico para perguntar sobre um assunto específico.

O Copilot permite que você altere o modelo durante um chat e use o modelo alternativo para gerar respostas para seus prompts.

Alterar o modelo usado pelo Copilot Chat não afeta o modelo usado para preenchimento de código do Copilot. Confira Alterando o modelo de IA para preenchimento de código do Copilot.

Note

- O suporte a vários modelos no Copilot Chat está em versão prévia pública e está sujeito a alterações.

- O suporte para o GPT-4.5 só está disponível no Copilot Enterprise.

- Você só pode usar um modelo de IA alternativo na exibição imersiva do Copilot Chat. Esta é a versão de página inteira de Copilot Chat que é exibida em https://github.com/copilot. O painel do Copilot Chat sempre usa o modelo padrão.

Modelos de IA para o Copilot Chat

Os seguintes modelos estão disponíveis no modo imersivo do Copilot Chat:

- GPT-4o: esse é o modelo padrão do Copilot Chat. Trata-se de um modelo versátil e multimodal que se destaca no processamento de texto e imagem e foi desenvolvido para fornecer respostas rápidas e confiáveis. Ele também tem desempenho superior em idiomas diferentes do inglês. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O GPT-4o é hospedado no Azure.

- GPT-4.5: esse modelo foi criado com funcionalidades avançadas em intuição, estilo de escrita e amplo conhecimento. Ele tem um bom desempenho com solicitações criativas e fornece respostas confiáveis para consultas de conhecimento obscuro. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O GPT-4.5 é hospedado no Azure.

- Claude Sonnet 3.7: esse modelo, como o predecessor, se destaca em todo o ciclo de vida de desenvolvimento de software, do design inicial e correções de bugs à manutenção e otimizações. Ele também tem funcionalidades de raciocínio que podem ser habilitadas com a seleção da versão de raciocínio do modelo, o que pode ser particularmente útil em cenários de agente. Saiba mais sobre as funcionalidades do modelo ou leia o card de modelo. O GitHub Copilot usa o Claude Sonnet hospedado no Amazon Web Services.

- Claude Sonnet 3.5: esse modelo se destaca na codificação de tarefas em todo o ciclo de vida de desenvolvimento de software, do design inicial e correções de bugs à manutenção e otimizações. Saiba mais sobre as funcionalidades do modelo ou leia o card de modelo. O GitHub Copilot usa o Claude Sonnet hospedado no Amazon Web Services.

- Gemini 2.0 Flash: esse modelo tem recursos de codificação, matemática e raciocínio fortes que o tornam adequado para ajudar no desenvolvimento de software. Para obter informações sobre os recursos do Gemini 2.0 Flash, consulte o blog da Google para desenvolvedores e a documentação do Google Cloud. Para obter detalhes sobre a política de tratamento de dados da Google, consulte IA Generativa e governança de dados no site da Google.

- o1: esse modelo é focado no raciocínio avançado e na resolução de problemas complexos, em particular em matemática e ciências. A resposta dele é mais lenta em comparação com o modelo GPT-4o. Você pode fazer 10 solicitações para esse modelo por dia. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O o1 é hospedado no Azure.

- o3-mini: esse modelo é a próxima geração de modelos de raciocínio, após o o1 e o o1-mini. O modelo o3-mini supera o o1 em parâmetros de comparação de codificação com tempos de resposta comparáveis ao o1-mini, proporcionando uma qualidade aprimorada quase na mesma latência. Ele é mais adequado para a geração de código e operações de pequeno contexto. Você pode fazer 50 solicitações a esse modelo a cada 12 horas. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O o3-mini é hospedado no Azure.

Para obter mais informações sobre esses modelos, confira:

- Modelos GPT-4o, GPT-4.5, o1 e o3-mini do OpenAI: Modelos na documentação da plataforma OpenAI.

- Modelos Claude Sonnet do Anthropic: Como usar o Claude Sonnet no Copilot Chat.

- Modelo Gemini 2.0 Flash da Google: Usando Gemini 2.0 Flash no Copilot Chat.

Limitações dos modelos de IA para Copilot Chat

- Caso você queira usar as habilidades listadas na tabela acima, ou bases de dados de conhecimento, no site do GitHub, somente há suporte para os modelos GPT-4o, Claude Sonnet e Gemini 2.0 Flash.

- As versões experimentais de pré-lançamento dos modelos podem não interagir com todos os filtros corretamente, incluindo o filtro de detecção de duplicação.

Alterar seu modelo de IA

Essas instruções são para o Copilot no site do GitHub. Para o Visual Studio ou o VS Code, clique na guia correta no topo desta página.

Se você acessar o Copilot Chat por meio de uma assinatura do Copilot Business ou do Copilot Enterprise, sua organização ou empresa precisará conceder aos membros a capacidade de mudar para um modelo diferente. Confira Gerenciar políticas do Copilot na sua organização ou Gerenciando políticas e recursos do Copilot em sua empresa.

Note

Se você usa Copilot Extensions, elas poderão substituir o modelo selecionado.

-

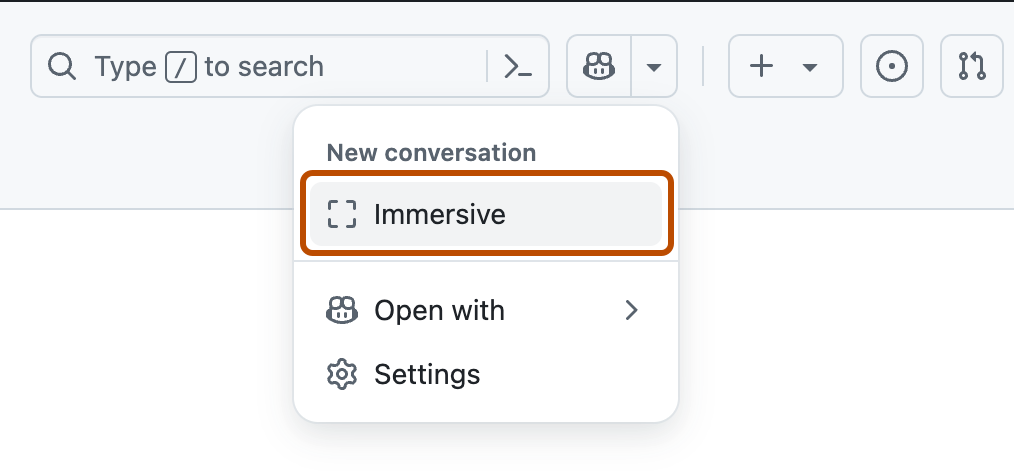

No canto superior direito de qualquer página no GitHub, clique no ao lado do ícone e clique em Immersive no menu suspenso.

-

Na parte superior da exibição imersiva, selecione o menu suspenso CURRENT-MODEL e clique no modelo de IA de sua escolha.

Note

- O suporte a vários modelos no Copilot Chat está em versão prévia pública e está sujeito a alterações.

- O suporte para o GPT-4.5 só está disponível no Copilot Enterprise.

Modelos de IA para o Copilot Chat

No momento, os seguintes modelos estão disponíveis por meio do Copilot Chat de vários modelos:

- GPT-4o: esse é o modelo padrão do Copilot Chat. Trata-se de um modelo versátil e multimodal que se destaca no processamento de texto e imagem e foi desenvolvido para fornecer respostas rápidas e confiáveis. Ele também tem desempenho superior em idiomas diferentes do inglês. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O GPT-4o é hospedado no Azure.

- GPT-4.5: esse modelo foi criado com funcionalidades avançadas em intuição, estilo de escrita e amplo conhecimento. Ele tem um bom desempenho com solicitações criativas e fornece respostas confiáveis para consultas de conhecimento obscuro. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O GPT-4.5 é hospedado no Azure.

- Claude Sonnet 3.7: esse modelo, como o predecessor, se destaca em todo o ciclo de vida de desenvolvimento de software, do design inicial e correções de bugs à manutenção e otimizações. Ele também tem funcionalidades de raciocínio que podem ser habilitadas com a seleção da versão de raciocínio do modelo, o que pode ser particularmente útil em cenários de agente. Saiba mais sobre as funcionalidades do modelo ou leia o card de modelo. O GitHub Copilot usa o Claude Sonnet hospedado no Amazon Web Services.

- Claude Sonnet 3.5: esse modelo se destaca na codificação de tarefas em todo o ciclo de vida de desenvolvimento de software, do design inicial e correções de bugs à manutenção e otimizações. Saiba mais sobre as funcionalidades do modelo ou leia o card de modelo. O GitHub Copilot usa o Claude Sonnet hospedado no Amazon Web Services.

- Gemini 2.0 Flash: esse modelo tem recursos de codificação, matemática e raciocínio fortes que o tornam adequado para ajudar no desenvolvimento de software. Para obter informações sobre os recursos do Gemini 2.0 Flash, consulte o blog da Google para desenvolvedores e a documentação do Google Cloud. Para obter detalhes sobre a política de tratamento de dados da Google, consulte IA Generativa e governança de dados no site da Google.

- o1: esse modelo é focado no raciocínio avançado e na resolução de problemas complexos, em particular em matemática e ciências. A resposta dele é mais lenta em comparação com o modelo GPT-4o. Você pode fazer 10 solicitações para esse modelo por dia. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O o1 é hospedado no Azure.

- o3-mini: esse modelo é a próxima geração de modelos de raciocínio, após o o1 e o o1-mini. O modelo o3-mini supera o o1 em parâmetros de comparação de codificação com tempos de resposta comparáveis ao o1-mini, proporcionando uma qualidade aprimorada quase na mesma latência. Ele é mais adequado para a geração de código e operações de pequeno contexto. Você pode fazer 50 solicitações a esse modelo a cada 12 horas. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O o3-mini é hospedado no Azure.

Para obter mais informações sobre esses modelos, confira:

- Modelos GPT-4o, GPT-4.5, o1 e o3-mini do OpenAI: Modelos na documentação da plataforma OpenAI.

- Modelos Claude Sonnet do Anthropic: Como usar o Claude Sonnet no Copilot Chat.

- Modelo Gemini 2.0 Flash da Google: Usando Gemini 2.0 Flash no Copilot Chat.

Alterar seu modelo de IA

Essas instruções são referentes ao VS Code. Para o Visual Studio ou para o Copilot no site do GitHub, clique na guia correta no topo desta página.

Se você acessar o Copilot Chat por meio de uma assinatura do Copilot Business ou do Copilot Enterprise, sua organização ou empresa precisará conceder aos membros a capacidade de mudar para um modelo diferente. Confira Gerenciar políticas do Copilot na sua organização ou Gerenciando políticas e recursos do Copilot em sua empresa.

Note

- Se você usa Copilot Extensions, elas poderão substituir o modelo selecionado.

- As versões experimentais de pré-lançamento dos modelos podem não interagir com todos os filtros corretamente, incluindo o filtro de detecção de duplicação.

- Para abrir a visualização de chat, clique no ícone de chat na barra de atividades ou pressione Control+Command+i (Mac)/Ctrl+Alt+i (Windows/Linux).

- No canto inferior direito da visualização de bate-papo, selecione o menu suspenso CURRENT-MODEL e clique no modelo de IA de sua escolha.

Note

O suporte a vários modelos no Copilot Chat está em versão prévia pública e está sujeito a alterações.

Modelos de IA para o Copilot Chat

No momento, os seguintes modelos estão disponíveis por meio do Copilot Chat de vários modelos:

- GPT-4o: esse é o modelo padrão do Copilot Chat. Trata-se de um modelo versátil e multimodal que se destaca no processamento de texto e imagem e foi desenvolvido para fornecer respostas rápidas e confiáveis. Ele também tem desempenho superior em idiomas diferentes do inglês. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O GPT-4o é hospedado no Azure.

- Claude Sonnet 3.7: esse modelo, como o predecessor, se destaca em todo o ciclo de vida de desenvolvimento de software, do design inicial e correções de bugs à manutenção e otimizações. Ele também tem funcionalidades de raciocínio que podem ser habilitadas com a seleção da versão de raciocínio do modelo, o que pode ser particularmente útil em cenários de agente. Saiba mais sobre as funcionalidades do modelo ou leia o card de modelo. O GitHub Copilot usa o Claude Sonnet hospedado no Amazon Web Services.

- Claude Sonnet 3.5: esse modelo se destaca na codificação de tarefas em todo o ciclo de vida de desenvolvimento de software, do design inicial e correções de bugs à manutenção e otimizações. Saiba mais sobre as funcionalidades do modelo ou leia o card de modelo. O GitHub Copilot usa o Claude Sonnet hospedado no Amazon Web Services.

- o1: esse modelo é focado no raciocínio avançado e na resolução de problemas complexos, em particular em matemática e ciências. A resposta dele é mais lenta em comparação com o modelo GPT-4o. Você pode fazer 10 solicitações para esse modelo por dia. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O o1 é hospedado no Azure.

- o3-mini: esse modelo é a próxima geração de modelos de raciocínio, após o o1 e o o1-mini. O modelo o3-mini supera o o1 em parâmetros de comparação de codificação com tempos de resposta comparáveis ao o1-mini, proporcionando uma qualidade aprimorada quase na mesma latência. Ele é mais adequado para a geração de código e operações de pequeno contexto. Você pode fazer 50 solicitações a esse modelo a cada 12 horas. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O o3-mini é hospedado no Azure.

Para obter mais informações sobre esses modelos, confira:

- Modelos GPT-4o, o1 e o3-mini da OpenAI: modelos na documentação da plataforma OpenAI.

- Modelos Claude Sonnet do Anthropic: Como usar o Claude Sonnet no Copilot Chat.

Alterando o modelo de IA para o Copilot Chat

Essas instruções são referentes ao Visual Studio. Para o VS Code ou para o Copilot no site do GitHub, clique na guia correta no topo desta página.

Para usar o Copilot Chat de vários modelos, você precisa usar o Visual Studio 2022 versão 17.12 ou posterior. Confira a Página de downloads do Visual Studio.

Se você acessar o Copilot Chat por meio de uma assinatura do Copilot Business ou do Copilot Enterprise, sua organização ou empresa precisará conceder aos membros a capacidade de mudar para um modelo diferente. Confira Gerenciar políticas do Copilot na sua organização ou Gerenciando políticas e recursos do Copilot em sua empresa.

Note

- Se você usa Copilot Extensions, elas poderão substituir o modelo selecionado.

- As versões experimentais de pré-lançamento dos modelos podem não interagir com todos os filtros corretamente, incluindo o filtro de detecção de duplicação.

- Na barra de menus do Visual Studio, clique em Exibir e no GitHub Copilot Chat .

- No canto inferior direito da exibição de chat, escolha o menu suspenso CURRENT-MODEL e selecione o modelo de IA de sua escolha.

Modelos de IA para o Copilot Chat

No momento, os seguintes modelos estão disponíveis por meio do Copilot Chat de vários modelos:

-

GPT-4o: esse é o modelo padrão do Copilot Chat. Trata-se de um modelo versátil e multimodal que se destaca no processamento de texto e imagem e foi desenvolvido para fornecer respostas rápidas e confiáveis. Ele também tem desempenho superior em idiomas diferentes do inglês. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O GPT-4o é hospedado no Azure.

-

Claude Sonnet 3.5: esse modelo se destaca na codificação de tarefas em todo o ciclo de vida de desenvolvimento de software, do design inicial e correções de bugs à manutenção e otimizações. Saiba mais sobre as funcionalidades do modelo ou leia o card de modelo. O GitHub Copilot usa o Claude Sonnet hospedado no Amazon Web Services.

-

Gemini 2.0 Flash: esse modelo tem recursos de codificação, matemática e raciocínio fortes que o tornam adequado para ajudar no desenvolvimento de software. Para obter informações sobre os recursos do Gemini 2.0 Flash, consulte o blog da Google para desenvolvedores e a documentação do Google Cloud. Para obter detalhes sobre a política de tratamento de dados da Google, consulte IA Generativa e governança de dados no site da Google.

-

o1: esse modelo é focado no raciocínio avançado e na resolução de problemas complexos, em particular em matemática e ciências. A resposta dele é mais lenta em comparação com o modelo GPT-4o. Você pode fazer 10 solicitações para esse modelo por dia. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O o1 é hospedado no Azure.

-

o3-mini: esse modelo é a próxima geração de modelos de raciocínio, após o o1 e o o1-mini. O modelo o3-mini supera o o1 em parâmetros de comparação de codificação com tempos de resposta comparáveis ao o1-mini, proporcionando uma qualidade aprimorada quase na mesma latência. Ele é mais adequado para a geração de código e operações de pequeno contexto. Você pode fazer 50 solicitações a esse modelo a cada 12 horas. Saiba mais sobre as funcionalidades do modelo e leia o card de modelo. O o3-mini é hospedado no Azure.

-

Modelos GPT-4o, o1 e o3-mini da OpenAI: modelos na documentação da plataforma OpenAI.

-

Modelos Claude Sonnet do Anthropic: Como usar o Claude Sonnet no Copilot Chat.

-

Modelo Gemini 2.0 Flash da Google: Usando Gemini 2.0 Flash no Copilot Chat.

Alterando o modelo de IA para o Copilot Chat

Estas instruções são para os IDEs do JetBrains. Para obter instruções sobre clientes diferentes, clique na guia apropriada na parte superior desta página.

Se você acessar o Copilot Chat por meio de uma assinatura do Copilot Business ou do Copilot Enterprise, sua organização ou empresa precisará conceder aos membros a capacidade de mudar para um modelo diferente. Confira Gerenciar políticas do Copilot na sua organização ou Gerenciando políticas e recursos do Copilot em sua empresa.

Note

- Se você usa Copilot Extensions, elas poderão substituir o modelo selecionado.

- As versões experimentais de pré-lançamento dos modelos podem não interagir com todos os filtros corretamente, incluindo o filtro de detecção de duplicação.

- Clique no ícone na barra de status.

- No menu pop-up, clique em Abrir GitHub Copilot Chat.

- No canto inferior direito da exibição do chat, selecione um modelo de IA de sua escolha no menu suspenso .